ClickHouse 是一个真正的列式数据库管理系统(DBMS)。在 ClickHouse 中,数据始终是按列存储的,包括矢量(向量或列块)执行的过程。只要有可能,操作都是基于矢量进行分派的,而不是单个的值,这被称为?矢量化查询执行?,它有利于降低实际的数据处理开销。

ClickHouse 是一个真正的列式数据库管理系统(DBMS)。在 ClickHouse 中,数据始终是按列存储的,包括矢量(向量或列块)执行的过程。只要有可能,操作都是基于矢量进行分派的,而不是单个的值,这被称为?矢量化查询执行?,它有利于降低实际的数据处理开销。 ClickHouse 是一个真正的列式数据库管理系统(DBMS)。在 ClickHouse 中,数据始终是按列存储的,包括矢量(向量或列块)执行的过程。只要有可能,操作都是基于矢量进行分派的,而不是单个的值,这被称为?矢量化查询执行?,它有利于降低实际的数据处理开销。

Elasticsearch是一个开源的分布式、RESTful 风格的搜索和数据分析引擎,它的底层是开源库Apache Lucene。 它可以被这样准确地形容:

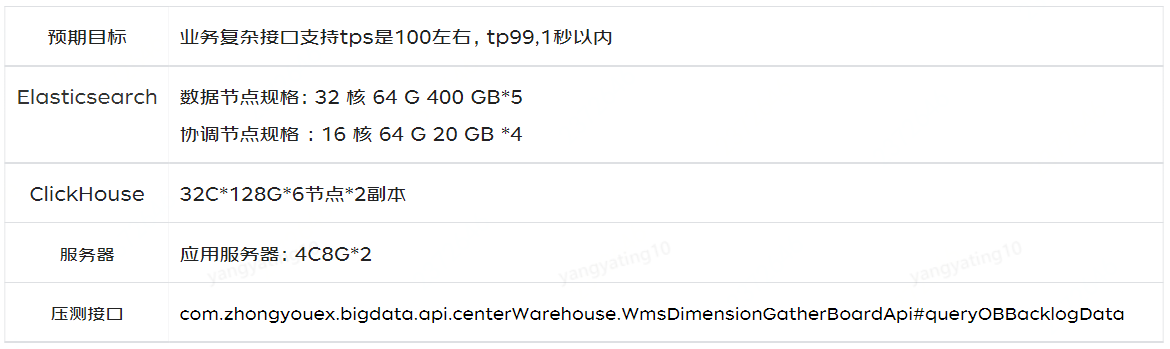

众所周知,ClickHouse在基本场景表现非常优秀,性能优于ES,但是我们实际的业务查询中有很多是复杂的业务查询场景,甚至是大数量的查询,所以为了在双十一业务峰值来到前,确保大促活动峰值业务稳定性,针对ClickHouse 和Elasticsearch在我们实际业务场景中是否拥有优秀的抗压能力,通过这次性能压测,探测系统中的性能瓶颈点,进行针对性优化,从而提升系统性能。

为什么会选择这个(queryOBBacklogData)接口呢?

/*** 切ck-queryOBBacklogData* @param queryBO* @return*/public OutboundBacklogRespBO queryOBBacklogDataCKNew(OutboundBacklogQueryBO queryBO) {log.info(" queryOBBacklogDataCK入参:{}", JSON.toJSONString(queryBO));// 公共条件-卡最近十天时间String commonStartTime = DateUtils.getTime(DateUtil.format(new Date(), DateUtil.FORMAT_DATE), DateUtils.ELEVEN_AM, 1, -10);String commonEndTime = DateUtils.getTime(DateUtil.format(new Date(), DateUtil.FORMAT_DATE), DateUtils.ELEVEN_AM, 1, 1);// 越库信息-待越库件数&待越库任务数WmsObCrossDockQueryBo wmsObCrossDockQueryBo = wmsObCrossDockQueryBoBuilder(queryBO,commonStartTime, commonEndTime);log.info("queryOBBacklogDataCK-wmsObCrossDockQueryBo: {}", JSON.toJSONString(wmsObCrossDockQueryBo));CompletableFuture<OutboundBacklogRespBO> preCrossDockInfoCF = CompletableFuture.supplyAsync(() -> wmsObCrossDockMapper.preCrossDockInfo(wmsObCrossDockQueryBo), executor);// 集合任务信息-待分配订单WmsObAssignOrderQueryBo wmsObAssignOrderQueryBo = wmsObAssignOrderQueryBoBuilder(queryBO, commonStartTime, commonEndTime);log.info("queryOBBacklogDataCK-wmsObAssignOrderQueryBo: {}", JSON.toJSONString(wmsObAssignOrderQueryBo));CompletableFuture<Integer> preAssignOrderQtyCF = CompletableFuture.supplyAsync(() -> wmsObAssignOrderMapper.preAssignOrderInfo(wmsObAssignOrderQueryBo), executor);// 拣货信息-待拣货件数&待拣货任务数WmsPickTaskQueryBo wmsPickTaskQueryBo = wmsPickTaskQueryBoBuilder(queryBO, commonStartTime, commonEndTime);log.info("queryOBBacklogDataCK-wmsPickTaskQueryBo: {}", JSON.toJSONString(wmsPickTaskQueryBo));CompletableFuture<OutboundBacklogRespBO> prePickingInfoCF = CompletableFuture.supplyAsync(() -> wmsPickTaskMapper.pickTaskInfo(wmsPickTaskQueryBo), executor);// 分播信息-待分播件数&待分播任务WmsCheckTaskDetailQueryBo wmsCheckTaskDetailQueryBo = wmsCheckTaskDetailQueryBoBuilder(queryBO, commonStartTime, commonEndTime);log.info("queryOBBacklogDataCK-wmsCheckTaskDetailQueryBo: {}", JSON.toJSONString(wmsCheckTaskDetailQueryBo));CompletableFuture<OutboundBacklogRespBO> preSowInfoCF = CompletableFuture.supplyAsync(() -> wmsCheckTaskDetailMapper.checkTaskDetailInfo(wmsCheckTaskDetailQueryBo), executor);// 发货信息-待发货件数WmsOrderSkuQueryBo wmsOrderSkuQueryBo = wmsOrderSkuQueryBoBuilder(queryBO, commonStartTime, commonEndTime);log.info("queryOBBacklogDataCK-wmsOrderSkuQueryBo: {}", JSON.toJSONString(wmsOrderSkuQueryBo));CompletableFuture<Integer> preDispatchCF = CompletableFuture.supplyAsync(() -> wmsOrderSkuMapper.preDispatchInfo(wmsOrderSkuQueryBo), executor);return processResult(preCrossDockInfoCF, preAssignOrderQtyCF, prePickingInfoCF, preSowInfoCF, preDispatchCF);}

wms.wms_ob_cross_dockwms.wms_ob_assign_orderwms.wms_picking_task.wms.wms_check_task_detailwms.wms_order_sku

select(ifnull(sum(m.shouldBeCrossedDockQty),0) -ifnull(sum(m.satisfiedCrossedDockQty),0)) as preCrossStockSkuQty,count(m.docId) as preCrossStockTaskQtyfromwms.wms_ob_cross_dock m finalprewherem.createTime >= '2021-12-03 11:00:00'and m.createTime <= '2021-12-14 11:00:00'and m.warehouseNo = '279_1'and m.orderType = '10'and tenantCode = 'TC90230202'wherem.deleted = 0and m.deliveryDestination = '2'and m.shipmentOrderDeleted = 0and m.status = 0

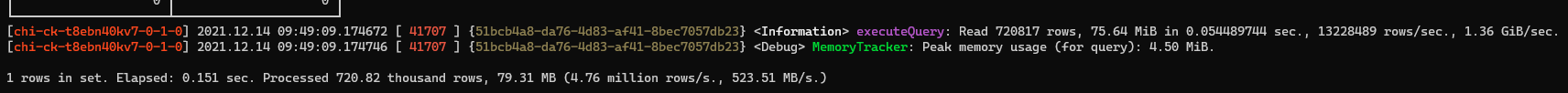

从上面SQL截图可以看出,查询待越库件数&待越库任务数,共读了720817行数据

select count(distinct m.orderNo) as preAssignedOrderQtyfrom wms.wms_ob_assign_order m finalprewherem.createTime >= '2021-12-03 11:00:00'and m.createTime <= '2021-12-14 11:00:00'and m.warehouseNo = '361_0'and tenantCode = 'TC90230202'where m.taskassignStatus = 0and m.deliveryDestination = 2and m.stopProductionFlag = 0and m.deleted = 0and m.orderType = 10

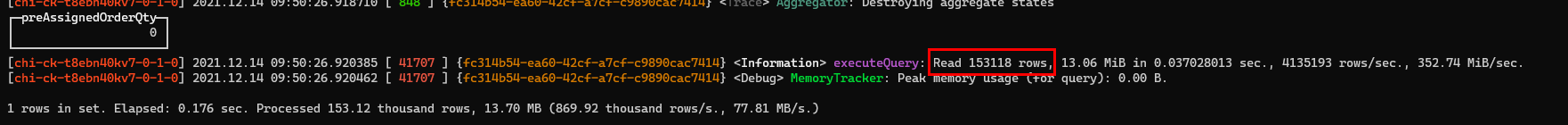

从上面SQL截图可以看出,查询集合任务信息-待分配订单,共读了153118行数据

select minus(toInt32(ifnull(sum(m.locateQty), toDecimal64(0, 4))),toInt32(ifnull(sum(m.pickedQty), toDecimal64(0, 4)))) as prePickingSkuQty,count(distinct m.taskNo) as prePickingTaskQtyfrom wms.wms_picking_task m finalprewherem.shipmentOrderCreateTime >= '2021-12-03 11:00:00'and m.shipmentOrderCreateTime <= '2021-12-14 11:00:00'and m.warehouseNo = '286_1'and tenantCode = 'TC90230202'where m.pickingTaskDeleted = 0and m.deliveryDestination = 2and m.pickLocalDetailDeleted = 0and m.shipmentOrderDeleted = 0and m.orderType = 10and (m.operateStatus = 0 or m.operateStatus = 1)

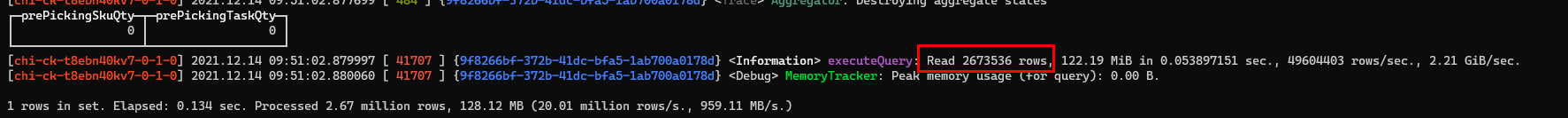

从上面SQL截图可以看出,查询拣货信息-待拣货件数&待拣货任务数,共读了2673536行数据

select minus(toInt32(ifnull(sum(m.locateQty), toDecimal64(0, 4))),toInt32(ifnull(sum(m.pickedQty), toDecimal64(0, 4)))) as prePickingSkuQty,count(distinct m.taskNo) as prePickingTaskQtyfrom wms.wms_picking_task m finalprewherem.shipmentOrderCreateTime >= '2021-12-03 11:00:00'and m.shipmentOrderCreateTime <= '2021-12-14 11:00:00'and m.warehouseNo = '279_1'and tenantCode = 'TC90230202'where m.pickingTaskDeleted = 0and m.deliveryDestination = 2and m.pickLocalDetailDeleted = 0and m.shipmentOrderDeleted = 0and m.orderType = 10and (m.operateStatus = 0 or m.operateStatus = 1)

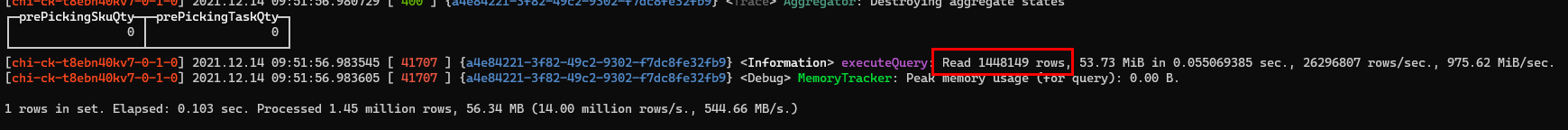

从上面SQL截图可以看出,查询分播信息-待分播件数&待分播任务,共读了1448149行数据

select ifnull(sum(m.unTrackQty), 0) as unTrackQtyfrom wms.wms_order_sku m finalprewherem.shipmentOrderCreateTime >= '2021-12-03 11:00:00'and m.shipmentOrderCreateTime <= '2021-12-14 11:00:00'and m.warehouseNo = '280_1'and m.orderType = '10'and m.deliveryDestination = '2'and tenantCode = 'TC90230202'where m.shipmentOrderDeleted <> '1'and m.ckDeliveryTaskDeleted <> '1'and m.ckDeliveryTaskDetailDeleted <> '1'and m.ckDeliveryTaskStatus in ('1','0','2')

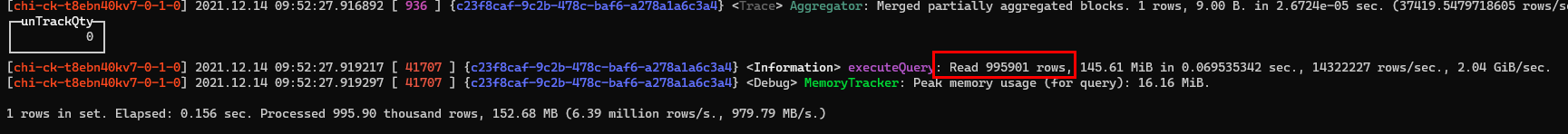

从上面SQL截图可以看出,查询发货信息-待发货件数,共读了99591行数据

为了尽可能发挥性能压测作用,性能压测环境应当尽可能同线上环境一致,所以我们使用了和线上一样的环境

Forcebot(http://forcebot.jd.com) 是专门为开发人员、测试人员提供的性能测试平台,通过编写脚本、配置监控、设置场景、启动任务、实时监控、日志定位、导出报告一系列操作流程来完成性能测试,灵活的脚本配置满足同步、异步、集合点等多种发压模式。

帮助文档(http://doc.jd.com/forcebot/helper/)

clickhouse数据服务:32C128G6节点2副本

应用服务器:4核8G2

maxTotal=16

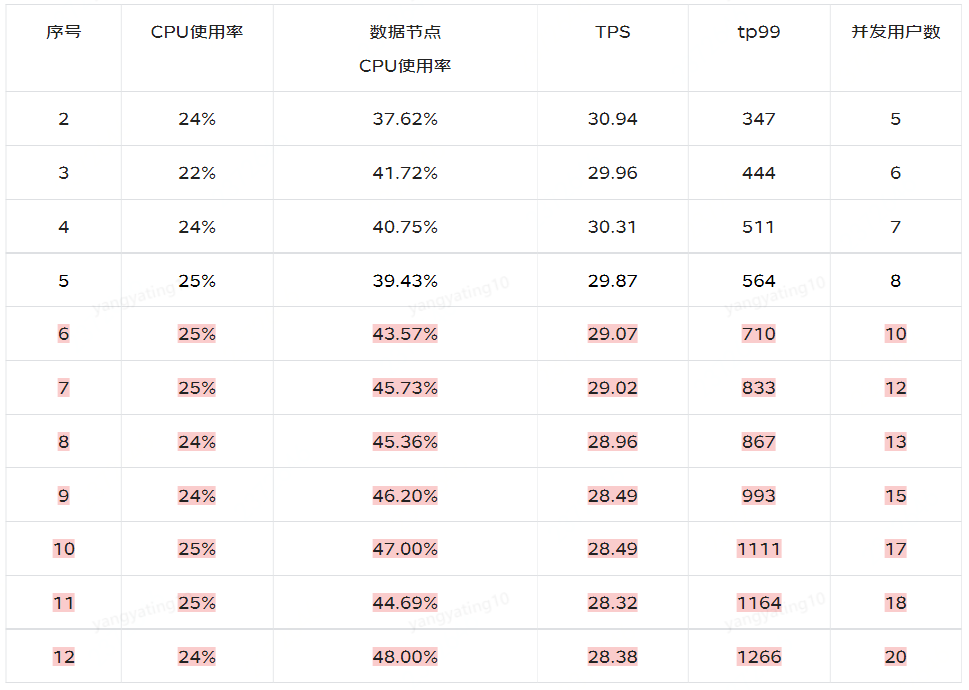

注:每次压测前,一定要观察每个数据节点的cpu使用率

注:从上面压测过程中,序号6-12可以看出,并发用户数在增加,但tps没有幅度变化,检查发现bigdata dbcp数据库链接池最大线程数未配置,默认最大线程数是8,并发用户数增加至8以后,clickhouse cpu稳定在40%~50%之间不再增加,应用服务器CPU稳定在25%左右。

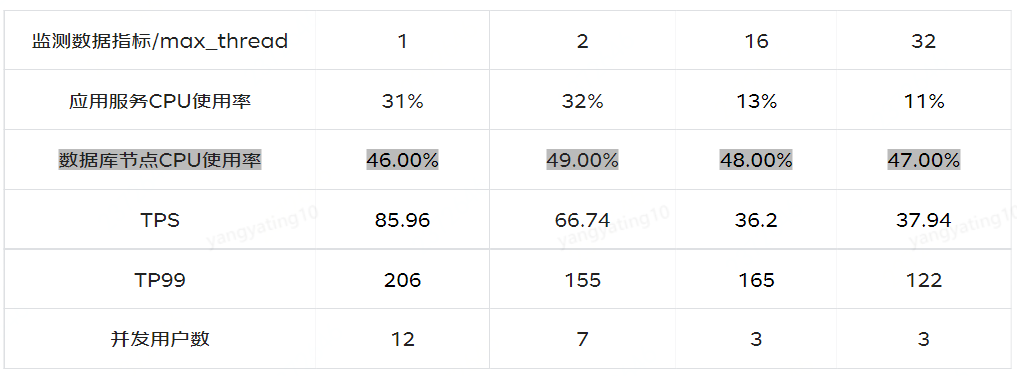

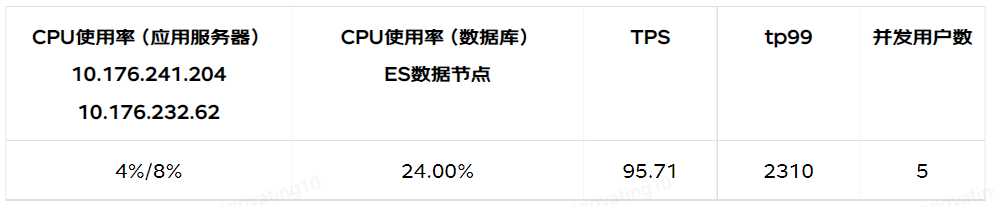

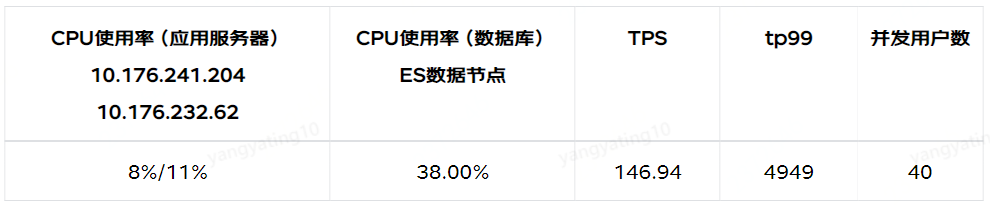

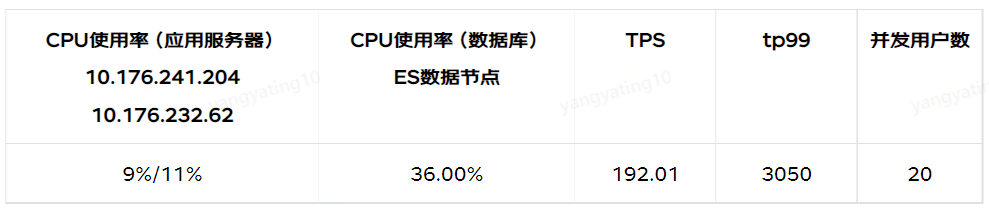

之后我们调整maxTotal=50,通过调整max_thread不同的值,数据库节点CPU使用率保持在50%左右,来查看相应的监测数据指标:应用服务CPU使用率、TPS、TP99、并发用户数。

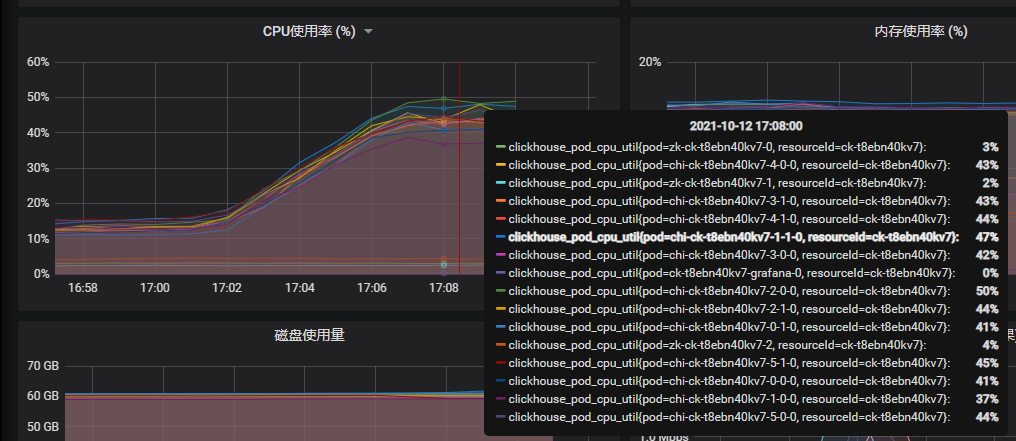

clickhouse数据节点,CPU使用率:

Elasticsearch数据服务:32C128G6节点2副本

应用服务器:4核8G2

Elasticsearch同样保持数据库服务CPU使用率达到(50%左右),再监控数据指标tps、tp99

调整指标如下:coordinating协调节点数、 数据节点、poolSize

指标1:coordinating=2,数据节点=4,poolSize=400

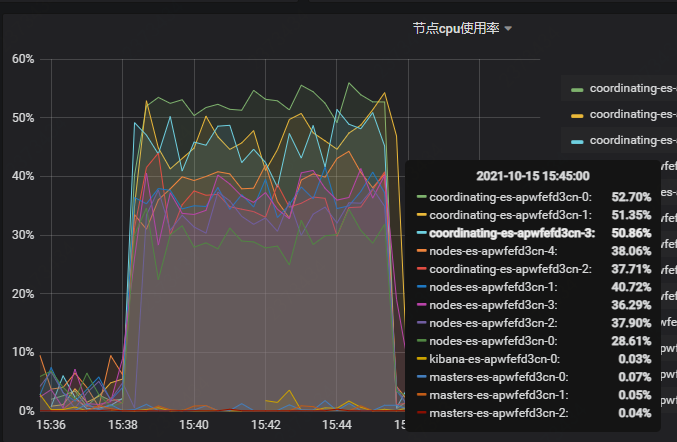

注:在压测的过程中发现,coordinating节点的cpu使用率达到51.69%,负载均衡的作用受限,所以协调节点需扩容2个节点

指标2:coordinating=4,数据节点=5,poolSize=800

注:在压测的过程中,发现CPU使用率(数据库)ES数据节点在40%左右的时候,一直上不去,查看日志发现activeCount已经达到797,需要增加poolSize值

指标3:coordinating=4,数据节点=5,poolSize=1200

注:压测过程中,发现coordinating协调节点还是需要扩容,不能支持现在数据节点cpu使用率达到50%

Elasticsearch数据节点及协调节点,CPU使用率:

我们在压测的过程中发现一些之前在开发过程中没发现的问题,首先bdcp数bigdata应用服务器,使用的线程池最大线程数为8时,成为瓶颈,用户数增加至8以后, clickhouse的cpu稳定在40%~50%之间不在增加,应用服务器CPU稳定在25%左右,其次warehouse集群协调节点配置低,协调节点CPU使用率高,最后是clickhouse-jdbc JavaCC解析sql效率低。

1)clickhouse对并发有一定的支持,并不是不支持高并发,可以通过调整max_thread提高并发

2)在并发方面Elasticsearch比clickhouse支持的更好,但是相应的响应速度慢很多

综合考量,我们认为clickhouse足以支撑我们的业务诉求

作者:潘雪艳